1. 설계 목적의 차이

■ CPU(중앙처리장치)

: ‘범용 처리기’로, 운영체제 구동, 앱 실행, 논리적 판단, 입력·출력 제어 등 다양한 명령을 순차적으로 빠르게 처리하도록 설계되어 있습니다.

→ 예: 문서 작성, 웹 브라우징, 프로그램 실행 등

■ GPU(그래픽처리장치)

: 원래는 화면의 그래픽·영상 데이터를 병렬로 계산하기 위해 만들어졌습니다.

그러나 현재는 AI·딥러닝처럼 대량의 연산을 동시에 수행하는 작업에 특화되어 CPU를 보조하거나 대체하기도 합니다.

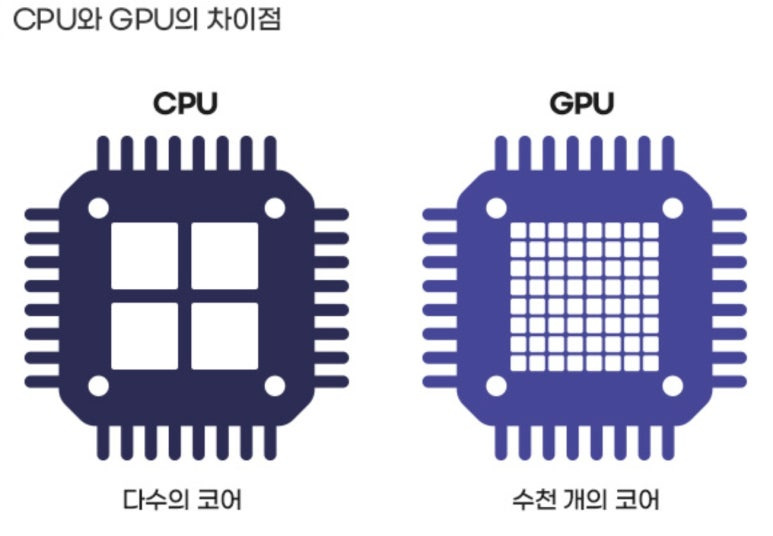

2. 구조적 차이

|

구분

|

CPU

|

GPU

|

|

코어 수

|

적음 (보통 4~16개)

|

많음 (수백~수천 개)

|

|

처리 방식

|

직렬 처리(Sequential)

|

병렬 처리(Parallel)

|

|

설계 초점

|

복잡한 연산, 순차적 명령 처리

|

단순 연산을 대량으로 동시에 처리

|

|

메모리 접근

|

빠르지만 제한적

|

대규모 데이터 처리 가능

|

|

주 용도

|

운영체제, 일반 앱, 제어 로직

|

영상처리, AI 연산, 딥러닝, 과학 계산

|

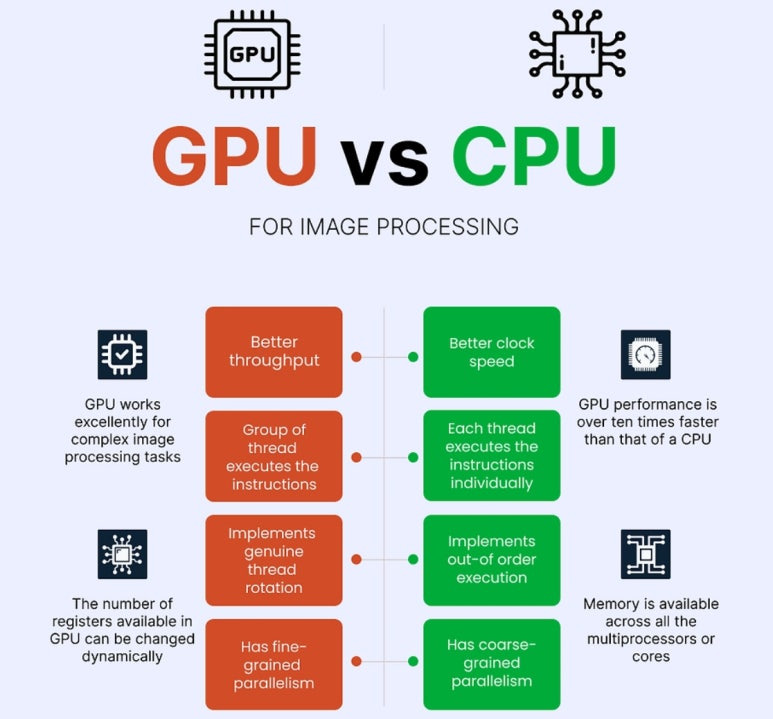

3. 성능 비교 예시

■ CPU는 ‘두뇌형’: 문제를 하나씩 논리적으로 푸는 전문가.

■ GPU는 ‘근육형’: 단순하지만 수천 명이 동시에 같은 일을 처리하는 팀.

예를 들어, AI 학습(딥러닝)에서는 수백만 개의 연산을 동시에 처리해야 하므로 GPU가 CPU보다 수십~수백 배 빠릅니다.

반면, 운영체제 실행이나 프로그램 제어 로직처럼 순차적인 작업에는 CPU가 적합합니다.

4. 실제 활용 분야

■ CPU: OS 제어, 문서작업, 웹서버 운영, 데이터베이스 등

■ GPU: AI 학습/추론, 자율주행, 3D 그래픽, 영상 렌더링, 과학 시뮬레이션 등

5. 마무리하며

👉 CPU는 “뇌”, GPU는 “근육”

CPU가 지시하고 GPU가 대규모 연산을 수행하는 구조로,

현대 컴퓨팅에서는 두 장치가 협력하여 성능을 극대화합니다.

AI 시대에는 GPU의 중요성이 폭발적으로 커지고 있습니다 —

그래서 엔비디아(NVIDIA)가 ‘AI 반도체 제왕’으로 불리는 이유죠 💡

<참고> “AI 연산에서 GPU가 CPU보다 100배 이상 빠른 이유”

AI 연산에서 GPU가 CPU보다 100배 이상 빠른 이유는 단순히 “성능이 좋다”가 아니라, 구조적·작동 원리 차이 때문입니다.

1. 연산 구조의 근본적 차이

|

구분

|

CPU

|

GPU

|

|

설계 목적

|

논리적 판단, 순차적 연산

|

대규모 수치 연산, 병렬 처리

|

|

코어 개수

|

4~16개 수준

|

수천 개 이상

|

|

처리 방식

|

직렬(Sequential)

|

병렬(Parallel)

|

|

명령 구조

|

복잡한 제어 중심

|

단순한 수학 연산 중심

|

|

메모리 접근

|

고속 캐시 중심

|

대용량 데이터 스트림 중심

|

👉 핵심 포인트:

AI 연산(특히 딥러닝)은 “하나의 작업을 반복적으로 수백만 번” 수행해야 하는 구조라,

GPU의 병렬 연산 구조가 CPU보다 훨씬 유리합니다.

2. 딥러닝은 ‘행렬 연산’ 중심

딥러닝 신경망은 수많은 가중치(weight)와 입력(input)을 곱하고 더하는 연산의 반복입니다.

이건 ‘수천만 번의 행렬 곱셈(matrix multiplication)’ 문제입니다.

예를 들어,

Y = X × W + b (입력 × 가중치 + 편향)

이 계산을 CPU는 하나씩 순서대로,

GPU는 한 번에 수천 개씩 병렬로 처리합니다.

➡️ 즉, CPU는 1명 장인이 한 땀 한 땀 수작업,

GPU는 공장 라인에서 1만 명이 동시에 조립하는 구조입니다.

3. GPU의 내부 구성 특징

수천 개의 ALU(Arithmetic Logic Unit)

단순 덧셈·곱셈 연산을 초고속으로 병렬 처리

SIMD 구조(Single Instruction, Multiple Data)

같은 명령을 여러 데이터에 동시에 적용

고대역폭 메모리(HBM, GDDR6 등)

CPU의 DDR 메모리보다 5~10배 빠른 데이터 전송

Tensor Core (AI 전용 연산장치)

NVIDIA GPU에는 행렬 곱 전용 코어가 내장되어 있어

AI 학습 속도를 폭발적으로 향상시킵니다.

4. 성능 수치로 본 차이

CPU: 초당 약 수십 GFLOPS (10⁹ 연산)

GPU: 초당 수십~수백 TFLOPS (10¹² 연산)

👉 즉, 약 1000배에 가까운 차이가 나기도 합니다.

실제 딥러닝 학습에서는 GPU 1대가 CPU 100~300대 역할을 대신할 수 있습니다.

5. AI 연산 속도 차이의 본질

|

구분

|

CPU 중심

|

GPU 중심

|

|

명령

|

복잡한 논리 처리

|

단순 수학 반복

|

|

효율

|

논리적 판단에 강함

|

대규모 연산에 강함

|

|

AI 학습 속도

|

느림 (병목 현상 발생)

|

빠름 (동시 병렬 처리)

|

|

예시

|

엑셀, 운영체제

|

챗GPT, 이미지 생성, 음성 인식

|

🔍 6. 한 줄 통찰

“AI는 생각보다 단순한 반복 계산의 예술이다.

GPU는 이 ‘반복의 힘’을 극대화한 기계다.”

#GPU #CPU #AI연산 #딥러닝 #병렬처리 #엔비디아 #반도체 #AI가속 #행렬연산 #슈퍼컴퓨팅